大模型到底做大一点好?在B端还是C端更容易商业化?大模型在哪些领域能更快落地?当大家都在“碾压”大模型时,突围的法宝是什么?

7月5日,清华大学计算机系终身副教授、绵比智能联合创始人、首席科学家刘志远亮相上海,并在分论坛发表主旨演讲。会后,南都就大模型领域热点话题采访了刘志远。

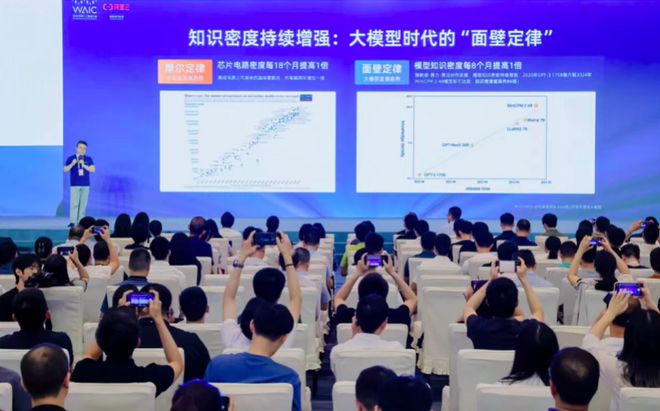

刘志远在“模型即服务(Mass)加速大模型应用”论坛上发表演讲。(论坛主办方供图)

他认为,人工智能的兴起拉开了通用人工智能的序幕,其影响力堪比2000年前后互联网的兴起。未来五到十年,大模型、通用人工智能技术将给整个行业、人类社会带来无限的想象空间。“我们应该把大模型看作‘更大’,它不只是具体的应用,而是类似于互联网、芯片层面的浪潮。”

刘志远告诉南都澳门一肖一码100精准2023,当前大模型技术还在快速迭代,技术竞争阶段可能持续两到三年甚至更长时间,在商业模式、产品运营设计等很多方面都会有竞争,因此需要探索AGI和大模型的商业模式,支撑它们发展。

模型越大越好吗?更重要的竞争是知识密度

从 到 Sora,“王弹”的频频成功,验证了规模定律(又称规模法则),即随着模型规模的增大,其性能也会随之提升。然而,在这一定律的驱动下,无限制地不断训练模型,让模型越来越大,就一定是好事吗?

7月5日,在2024年世界人工智能大会(WAIC 2024)加速大模型应用的分论坛上,刘志远提出了不一样的观点,他认为,相比较而言,大模型的知识密度和流程更加重要。

什么是知识密度?刘志远举了一个例子,同样是100道题的考试,有的人需要吃十顿饭才有精力做完,而有的人只需要一碗饭就能高效完成。显然,后者的知识密度更高。他还用一个公式来总结,知识密度=模型能力/推理计算功耗。简单来说,知识密度越高的模型,意味着它的能力越强,每次计算所需的参数规模就越小。

为了找到知识密度更高、效率更高的模型, 选择将大模型“滚”到端上。然而,在端上算力、内存、能耗有限的条件下,如何将知识凝练成更小的参数规模,对刘志远来说是一个更大的挑战。对此,在训练大模型之前,他选择先在“模型沙箱”中进行数百次演练,然后将找到的最优数据和超参数配置外推到大模型中。

刘志远介绍,过去80年来,人们见证了芯片制造工艺的不断增强,从而带来了终端算力的不断提升。大模型时代也会有自己的“摩尔定律”——根据他们的观察,模型知识密度呈现每8个月翻一番的规律。要让这个规律持续下去,需要在数据、模型框架、算法等方面不断探索科学方法,改进模型制造工艺。

刘志远认为,大模型时代也有自己的“摩尔定律”。图片由论坛主办方供图。

刘志远表示,大模型数据驱动的技术方向已经大致确定,但模型架构、算法、数据相关的技术方案还在高速迭代。接下来更重要的是继续完善模型流程,继续高速迭代相关技术方案。“模型流程的完善会带来模型知识密度的不断提升,两者的交汇将展现出边缘侧智能的巨大潜力。”

据棉比智能介绍,相较于2020年发布的拥有1750亿个参数的GPT-3,棉比将在2024年初发布-24亿个参数,性能与GPT-3相当但参数只有24亿个,知识密度提升约86倍。在今年WAIC大会上,棉比智能还正式宣布开源业界首个端侧大模型工具集”,助力开发者一键将大模型集成到APP中。

刘志远认为,未来的大模型是端云协同的模型,出于隐私保护、计算能力等考虑,将模型放到更靠近用户的地方,具有重要的价值和意义。据他介绍,棉比智能将在半年或一年内把GPT3.5级别的模型能力放到端侧,争取在未来两年内实现GPT4.0能力在端侧的落地。

大屏的市场机会在B端还是C端?先要技术过硬

自2022年底出现以来,国内外掀起了一波大尺寸模型热潮,各家企业也争相布局这一赛道。百模大战过去一年多,国内大尺寸模型赶上到了什么水平?

刘志远表示实践经验(2024年新奥开什么今晚)大模型如何卷土重来才能取胜?对话棉比智能首席科学家刘志远,从全球来看,目前推出的大模型仍处于世界一流水平,但中国的大模型已经展现出强大的追赶能力。去年下半年左右,国内不少一线大模型公司完成了GPT3.5的建设,目前已经达到接近GPT4.0的水平。

“仅从已发布的车型能力来看,基本会认为中国和美国的大车型有一年左右的代差。”不过,刘志远强调,更多要关注的是国外还未发布的车型——比如一些美国科技公司完全有能力不断推出车型,而国内大车型公司基本还在追赶目标,整体创新能力还不足。

大模型的价值在于实际应用,但市场机会在B端还是C端,业界众说纷纭。有人认为B端落地快,商业价值更大,但也有人,包括零一万事CEO李开复,坚持认为C端模式机会更多。与此同时,也有越来越多的人讨论AI是个烧钱的行业,投入越多,回报越可疑,市场开始失去耐心。

刘志远认为,现在讨论这个为时过早。AI的推出拉开了通用人工智能的序幕,其意义与2000年前后的互联网浪潮类似。“在这么早期的阶段,讨论到底是在C端做生意比较容易,还是在B端做生意比较容易等细小、具体的问题,有点模糊或不重要。”

刘志远告诉南都,大模式应该以“更大”来看待,它不只是一个具体的应用,而是一个相当于互联网甚至芯片级别的大浪潮,将会带来深远的影响。

他认为,目前大模型还处于早期阶段,初步验证了一种从数据到知识的学习和抽取的通用方法,可以帮助各行业更好地管理专业领域的知识,进行自动化应用。

但这项技术还远未“收敛”,仍在快速迭代,如果一家企业从未对大模型进行专门的积累和研究,那么在后续的竞争中很难保持在模型制造方面的领先地位。

“如果一个花费数千万元训练出来的模型,跟其他公司相比,存在代差,在模型效果、算力、能耗等方面没有竞争力,那肯定会被市场淘汰。总之,你首先要有更强的技术能力,才有可能赶上这一波大模型的发展。”刘志远说。

在刘志远看来,未来5到10年,大模型的竞争更多取决于相应技术的迭代。不过,在技术发展的过程中,也应该探索属于AGI和大模型的商业模式。因为未来大模型的竞争会夹杂着商业模式、产品操作设计等更全面的竞争,行业也会经历一轮又一轮的洗牌。

大模型未来何去何从?深入垂直专业领域提质增效

刘志远除了担任棉比智能首席科学家之外,还是一名教师。

他在清华大学讲授的课程中,有一门课叫《迈向通用人工智能》。为了解答学生对这门课的疑问,他开发了一款“AI老师”工具来辅助答疑。在收到数百名学生的积极反馈后,刘知远计划推广这一应用——给每一位进入2024级的新生配备一名成长助手,用AI帮助学生应对可能遇到的各种学业难题。

“我觉得今年下半年,我们会开始看到大模型所体现的通用知识管理能力在很多领域有各种不同的创新应用。我觉得清华大学的AI+教育创新很有意思。”刘志远对南都记者说。

其实,大模型不仅在教育领域有创新应用,在司法领域也有所体现。今年6月28日,深圳中院上线了由 开发的系统,该系统覆盖了立案、审卷、开庭、文书制作等85个庭审业务流程,还能针对一些典型纠纷预测调解难点,智能推送法律知识和典型案例。

“司法领域的大模式为何落地速度这么快?”刘志远认为,一方面是人工智能技术可以帮助法官提高审理质量和效率,让他们从大量重复性劳动中解脱出来。面对案件太多、法官太少的突出矛盾,法院对拥抱人工智能的热情很高。

另一个重要原因是信息化程度高,包括金融、互联网领域,“它们的数据是天然的,所以大模型很好用。”在刘志远看来,“制约大模型广泛应用的瓶颈不是技术,而是相关的信息化和数据准备。”

谈及大模型的发展趋势,刘志远认为,大模型会不断渗透到各个专业垂直领域。另外,数据质量决定了模型的上限——即使你有很多数据,如果不能从中提炼出高质量的内容,训练出来的模型也会受到限制。因此,刘志远认为,未来会有专门的数据治理团队,帮助各个领域更好地挖掘数据的价值。

撰稿人:南都李玲实习生杨柳来自上海

发表评论